Обмани меня

Распознавание лиц используется не только для проверки личности человека. В последние годы исследователи сосредоточились на других способах применения этой технологии. Например, на распознавании эмоций, пытаясь читать выражения лиц, чтобы понять, что чувствуют люди.

Так, компания из Гонконга Find Solution AI продает свои разработки школам и колледжам, где с их помощью сканируют лица учащихся и отслеживают их чувства в виртуальных классах. Теоретически, подобные системы могли бы определять, внимательны ли дети или они разочарованы, что указывает на трудности с усвоением материала в классе.

ИИ сканирует лица детей и отслеживают их чувства

Однако ученые, занимающиеся вопросами этики искусственного интеллекта, отмечают, что данная технология основана на сомнительной науке и что существуют серьезные этические проблемы в отношении того, за кем ведется наблюдение.

Соучредитель AI Now Institute и по совместительству старший научный сотрудник Microsoft Research Кейт Кроуфорд (Kate Crawford), опровергла утверждения Find Solution AI о том, что их технология может определять, что чувствуют дети.

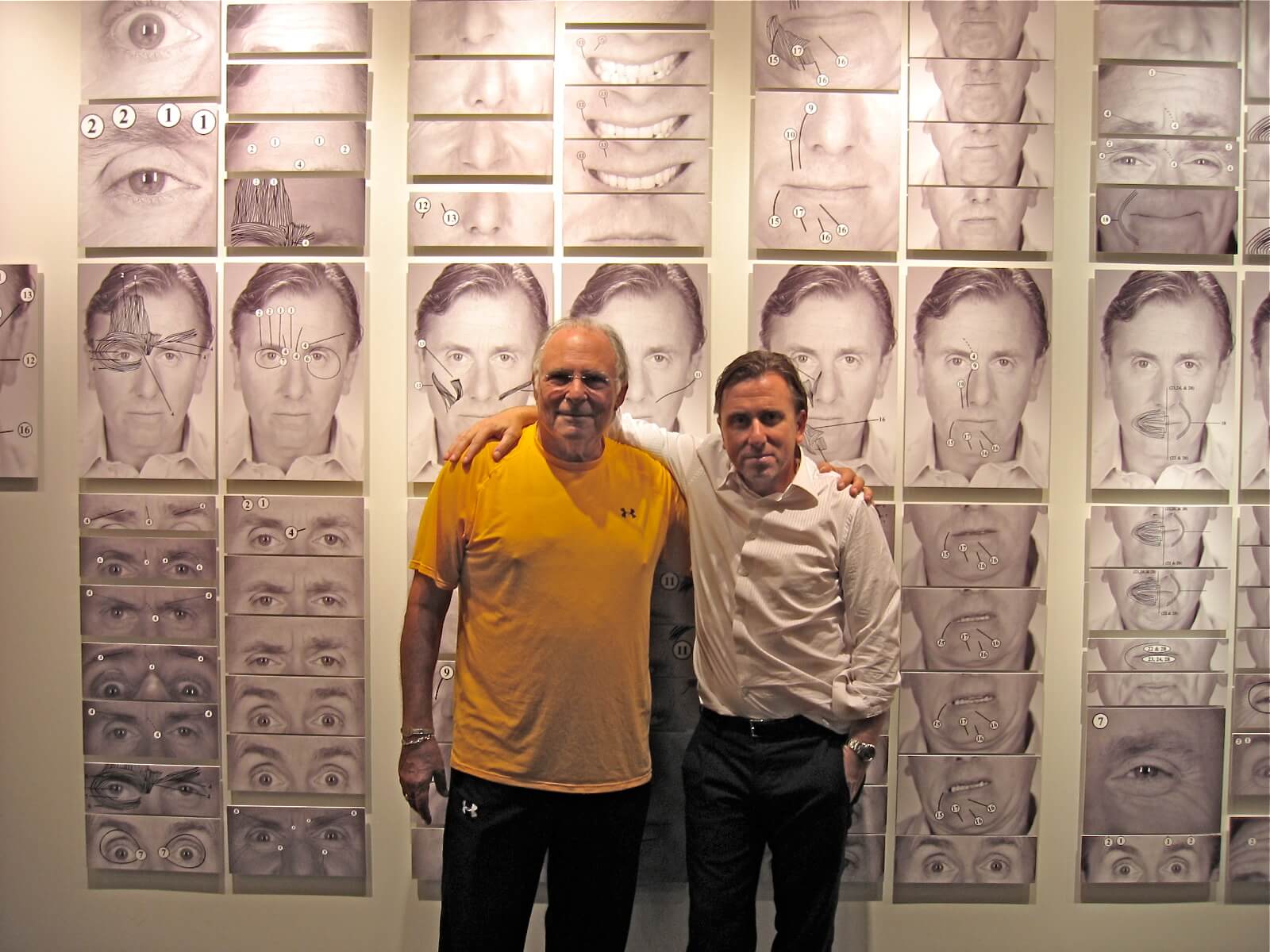

Find Solution AI и большинство подобных стартапов по распознаванию эмоций основывают свои технологии на работе психолога Пола Экмана (Paul Ekman). Экман опубликовал популярную работу о сходстве между выражениями лица, независимо от возраста, расы, языка или религии человека и популяризировал идею «семи универсальных эмоций». Актер Тим Рот даже сыграл в киноверсии работы Экмана в сериале «Обмани меня».

Пол Экман и Тим Рот

В реальном мире это исследование не нашло практического применения. Согласно отчетам Счетной палаты США и ACLU программа TSA, обучавшая агентов обнаруживать террористов с помощью работы Экмана, не имела под собой научных оснований, не привела к арестам и способствовала расовому профилированию.

Метаанализ 1000 исследований показал, что наука, связывающая выражение лица с нашими эмоциями, не является полностью универсальной. По словам исследователей, ожидаемое выражение лица людей соответствует их эмоциональному состоянию только в 20-30% случаев.

Однако, эта технология до сих пор применяется на детях в виртуальных классах, соискателях, выполняющих виртуальные собеседования, работниках Amazon с камерами во время доставки посылок и даже при допросах в полиции.

«Нам необходимо тщательно изучить, почему используют в сущности неисправные технологии для оценки характера в первую очередь на основе внешнего вида», - написали исследователи из AI Now Institute в своем отчете за 2019 год.

Перевод: Максим Родионов